Nvidia GeForce GTX 600: pierwsze zdjęcia karty z procesorem GK104

Premiera już w marcu?

W sieci pojawiły się pierwsze zdjęcia karty graficznej Nvidia GeForce z procesorem graficznym GK104, która rzekomo ma zadebiutować jeszcze w tym miesiącu.

Trzeba przyznać, że przez ostatnie dwa miesiące to właśnie AMD prowadziło na rynku kart graficznych. Na początku do sprzedaży trafiły wydajne modele Radeon HD 7950 i HD 7970, natomiast kilkanaście dni temu średnio wydajne Radeon HD 7750 i HD 7770. Warto również zaznaczyć, że już za parę dni ma nastąpić premiera kart Radeon HD 7850 i HD 7870, a więc konstrukcji o stosunkowo wysokiej wydajności i nie aż tak wygórowanej cenie jak w przypadku serii HD 7900.

Do sukcesu giganta z Sunnyvale przyczyniła się także zerowa konkurencja ze strony firmy Nvidia i brak potwierdzonych informacji o jej nowoczesnych kartach graficznych.. Okazuje się jednak, że już za niedługo sytuacja ta może się zmienić, bowiem dotarliśmy do pierwszych projektów i zdjęć jednej z flagowych konstrukcji „zielonych”

Opisywane zdjęcia przedstawiają próbkę inżynieryjną modelu z 28-nanometrowym procesorem graficznym Kepler GK104, a więc najprawdopodobniej kartę GeForce GTX 670 lub GTX 670 Ti. Tuż obok stosunkowo niewielkiego układu umieszczono osiem 256-megabajtowych (łącznie 2 GB) kości pamięci GDDR5 o 256-bitowej magistrali.

Referencyjna karta zostanie wyposażona w 5-fazową sekcję zasilania, która zostanie zamontowana nie pionowo (jak to zazwyczaj miało miejsca), a poziomo. Na jej śledziu pojawią się dwa wyjścia DVI, jedno HDMI i jedno Displayport, a obok niego dwa złącza SLI.

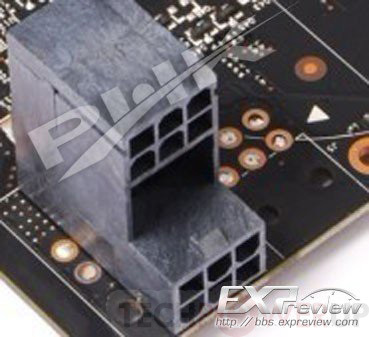

Warto również zwrócić uwagę na dodatkowe gniazda zasilające kartę. Producent po raz pierwszy zastosuje podwójne złącza, które z jednej strony ograniczą ilość zajmowanego miejsca na laminacie, ale z drugiej mogą uniemożliwić tworzenie jednoslotowych konstrukcji. Na projekcie powyżej można również zauważyć, iż PCB będzie przystosowane do montażu trzech takich złącz – dwóch 6-pinowych i jednego 8-pinowego.

Można więc przypuszczać, że do wyższych modeli (GeForce GTX 680?) będzie mogło być doprowadzone aż 375 W mocy – 75 W ze złącza PCI-Express 3.0 x16, 2x 75 W z wtyczek 6-pinowych i 150 W z wtyczki 8-pinowej. Czyżby zatem karty GeForce 600 charakteryzował wysoki pobór mocy?

|

Niepotwierdzone informacje wskazują również, iż premiera karty graficznej Nvidia GeForce z procesorem Kepler GK104 ma nastąpić już 23 marca. Czekamy zatem z niecierpliwością.

Więcej o kartach graficznych Nvidia Geforce 600:

- Nvidia GeForce GT 6x0 GK107: nieoficjalna wydajność karty graficznej w 3DMark 11

- Nvidia Kepler GK107: projekt karty GeForce GT 6x0

- Nvidia GeForce GTX 600: nieoficjalne specyfikacje układów

- Nvidia GeForce GTX 680: karty z 28 nm układami Kepler już w lutym?

Źródło: Expreview, ChipHell, TechPowerUp

.jpg/330x0x1.jpg)

.jpg/330x0x1.jpg)

![Amerykańskie wojsko i sztuczna inteligencja. Dzień Sądu jest bliski? [OPINIA]](http://cdn.benchmark.pl/thumbs/uploads/article/93801/MODERNICON/dfef86e432c60118ce8ad99b59ec2355fab92f34.jpg/175x0x1.jpg)

![AI nie będzie nam wybierało rządu! A może będzie? [OPINIA]](http://cdn.benchmark.pl/thumbs/uploads/article/93577/MODERNICON/2b77f552fbfa26c7e99620bb643f2dea6b143fd0.jpg/175x0x1.jpg)

Komentarze

106Takie newsy to żer dla trolli.

Mam nadzieję, że tak nie będzie. W dobie rosnących rachunków za prąd może być niewesoło. Ale w zamian za to powinny być wydajne.

Przecież jeżeli karta GTX580 jest tylko o ok. 10% wolniejsza od najszybszej karty ATI nowej generacji to wiadomo że Nvidia nie wypuści wolniejszej tylko co najmniej o 40-50% szybszej od swojej poprzedniej a to znaczy że będzie szybsza o ok 30-40% od ATI. Tyle, że jak ATI wywaliło takie ceny to ile teraz Nvidia będzie krzyczeć za swoje ?

A pomyśleć że kiedyś kibicowałem tej firmie że Nvidia to moloch a biedne maluczkie ATI musi konkurować z tą złą firmą a teraz sytuacja się zmieniła teraz to Ati jest zły policjant a Nvidia ten lepszy.

W sumie to obie firmy tworzą idealny przykład monopolu

To jest tak w moim odczuciu.

Dzwoni Nvidia do ATI i mówi:

-macie 3 miesiące zanim wypuścimy swoje karty i będą szybsze od waszych

Ati odpowiada:

-ok. to przez te 3 miechy chapiemy ile się da, walniemy wyższe ceny a gdy wy wypuścicie swoje i wycenicie je podobnie to wtedy my

zejdziemy z ceny a i tak wszyscy więcej zarobimy.

I tak to idzie latami 2 firmy zawsze się dogadają. Musieli by być idiotami żeby na prawdę ze sobą konkurować a cała reszta to marketing.

a co do pomysłu z podwójną kostką

to chyba na ryj padli

Czy naprawdę nikt z Was tego nie zauważył?!

Rozpisałem się trchę, konkludując liczy się cena/fps czy cena/wydajność per wat.

Parodia jak dla mnie. Do tej pory myślałem ze z firm tylko "Jabłko" ma taki fan klub ale oni przynajmniej mają normalne produkty dla normalnych ludzi a dzisiaj to już i tak dużo i za to trzeba zapłacić, ale za co płacić AMD ?

Mniejszy proces produkcji - powinny być tańsze.

Tylko nieznacznie szybsze od rocznych kart konkurencji a droższe o 50% - powinny być tańsze.

Apeluje do Was byście mieli trochę rozumu i nawet jak macie kasę na kartę za 3 tyś to żebyście nie dawali się nabijać firmie obracającej miliardami i nie nabijali kabzy min. spekulantom i grubym prezesom za pół produkt niech się najpierw wysilą bo niedługo za 5% wydajności będziemy bulić 100% ceny.

Pozdrawiam wszystkich nie fanów a normalnych klientów którym trzeba czegoś więcej niż jakiegoś cwaniaka od marketingu by tak skutecznie wyprać umysł. Jeżeli Nvidia będzie szybsza o powiedzmy 10% od Ati to karty hi-end powinny być za jakieś 4 tys dostępne.

Przy tym co zrobiło AMD z cenami to powinien być bojkot tej firmy na całego wtedy by zaczęto szanować nas Polaków bo nas jest 40 mln ludzi nie jesteśmy kur.a jakąś wysepką z 3 murzynami na bananowcu to jest kupa potencjalnych klientów zwłaszcza że u nas rządzi niepodzielnie pecet a ceny wyższe jak dla bogatych Niemców czy hamburgerów.

Aby przekonać się czy tak będzie naprawdę, musimy poczekać. Najbliższą okazję do prezentacji swoich nowych kart firma będzie mieć już w przyszłym tygodniu podczas targów CeBIT, lub podczas organizowanej przez siebie w San Francisco konferencji Game Developers Conferencje 2012

BTW jeśli już wyciekają pierwsze zdjęcia to znaczy, że premiera już tuż tuż. Ciekawi mnie tylko jakiego producenta (partnera) jest ta karta (żaden Fermi nie miał płytki w tym kolorze).

"będzie mogło być doprowadzone aż 375 W mocy" taaa a o Radeonie HD 7970 też teoretycznie można powiedzieć, że może brać niemal 300 W (patrząc na wtyczki). Trzeba czekać na testy.

Jakim sukcesie... zawiewa to niebywałym funboystwem...