Konferencja otwierająca wydarzenie Google I/O 2025 została w całości zdominowana przez generatywną sztuczną inteligencję. Google chce umieścić AI we wszystkich twoich aplikacjach, a nawet na twojej twarzy.

Już w 2017 roku szef Google’a ogłosił "ważne przejście ze świata mobile-first do świata AI-first", ale dopiero teraz czuć, że wizję tę naprawdę udaje się realizować dzięki dużym modelom językowym z rodziny Gemini.

Jeszcze przed Google I/O 2025 dało się wyczuć, co się święci, bo przecież nowa wersja Androida została wyjątkowo zaprezentowana z tygodniowym wyprzedzeniem na osobnym wydarzeniu. Dziś już wiemy, że wszystko po to, by zrobić miejsce dla innych produktów i móc przez bite dwie godziny mówić o Gemini. Jak zauważył sam Sundar Pichai, słowo to padło podczas samej prezentacji 95 razy, a przecież było to jedynie otwarcie dwudniowego wydarzenia.

AI Mode, czyli Google przestaje być wyszukiwarką, a staje się odpowiadarką i wykonywarką

Sporą część prezentacji poświęcono nowej funkcji AI Mode, która trafiła właśnie do wyszukiwarki Google, choć na razie tylko w USA. Tryb ten przeprowadza wiele wyszukiwań w imieniu użytkownika i udziela gotowej odpowiedzi nawet na bardzo złożone zapytania. Szukając noclegu nie trzeba będzie już samemu przeszukiwać ofert z całego miasta, bo wystarczy w zapytaniu do Google’a zawrzeć precyzyjne kryteria dotyczące lokalizacji, ceny czy wyżywienia.

Wyszukiwarkę zintegrowano także z trybem agenta AI, który będzie mógł w imieniu użytkownika podjąć działania na wybranych stronach internetowych. Funkcja ta została zademonstrowana na przykładzie poszukiwań biletu na mecz, kiedy to sztuczna inteligencja sama wypełni formularze na witrynach sprzedawców. Bliźniaczy (nomen omen) Agent Mode trafi także do aplikacji Gemini.

Google AI Mode ma także pomóc w robieniu zakupów i ułatwić wyszukiwanie produktów spełniających ściśle określone kryteria. Firma opracowała nawet wirtualną przymierzalnię ubrań, która ma podmieniać garderobę na zdjęciu użytkownika z uwzględnieniem jego sylwetki i sposobu układania się materiału.

Na razie Google nie sprecyzował, kiedy AI Mode trafi do Europy.

Google Flow oraz Veo 3 zrobią z ciebie filmowca i dźwiękowa

Dopiero co użytkownikom Gemini udostępniony został model generowania wideo Veo 2, a już pojawił się jego następca. Veo 3 ma na podstawie słownych opisów tworzyć jeszcze lepsze filmy, które - tu nowość - wzbogacone są o generowaną przez AI mowę i efekty dźwiękowe. Intro imprezy Google I/O 2025 miało zostać w całości wygenerowane właśnie za pomocą tego narzędzia.

Google stworzył także zupełnie nowy edytor wideo AI o nazwie Flow, za pomocą którego będzie można nie tylko tworzyć kolejne sceny na podstawie promptów, ale i precyzyjnie je edytować oraz montować.

Przy okazji Google zademonstrował także nowy model tworzenia obrazów Imagen 4, który ma tworzyć grafiki o lepszej jakości, lepiej radzić sobie z tekstem i działać nawet 10 razy szybciej.

Edytor Google Flow na razie dostępny jest tylko w USA i - podobnie jak model Veo 3 - wymaga wykupienia subskrypcji. A skoro już o subskrypcjach mowa…

Google AI Ultra, czyli nawet 1200 zł miesięcznie za dostęp do AI

Google wprowadził zmiany w swojej ofercie abonamentowej. Dotychczasowy plan Google One AI Premium został przemianowany na prostsze Google AI Pro, a dołączył do niego abonament Google AI Ultra. Za ponad 1200 zł/mies. użytkownicy zyskają dostęp do najnowszych i najbardziej zaawansowanych funkcji AI, w tym tych, które znajdują się we wczesnej fazie rozwoju.

| Google AI Pro 97,99 zł/mies. (0 zł pierwszy miesiąc) | Google AI Ultra 1229,99 zł/mies. (609,99 zł/mies. przez 3 miesiące) |

|---|---|

| Gemini: Dostęp do modelu 2.5 Pro, Deep Research oraz generowania wideo z Veo 2. | Gemini: Najwyższe limity i ekskluzywny dostęp do 2.5 Pro Deep Think (zaawansowany model rozumowania – wkrótce) oraz Veo 3. |

| Flow: Narzędzie do tworzenia filmów AI zbudowane na bazie Veo do scen i historii filmowych (tylko USA). | Flow: Najwyższe limity z dostępem do Veo 3 i funkcje premium (np. składniki do wideo). |

| Whisk: Wyższe limity dla funkcji obraz-wideo z użyciem Veo 2. | Whisk: Najwyższe limity dla funkcji obraz-wideo z użyciem Veo 2. |

| NotebookLM: Asystent do badań i pisania z 5× więcej podsumowań audio, notatników i innych. | NotebookLM: Najwyższe limity i najlepsze możliwości modelu (wkrótce). |

| Gemini w Gmailu, Dokumentach i innych: Dostęp do Gemini w aplikacjach Google. | Gemini w Gmailu, Dokumentach i innych: Najwyższe limity korzystania z Gemini w aplikacjach Google. |

| Gemini w Chrome: Asystent do przeglądania internetu (tylko USA). | Gemini w Chrome: Asystent do przeglądania internetu (tylko USA). |

| Pamięć: 2 TB (Zdjęcia, Dysk, Gmail). | Pamięć: 30 TB (Zdjęcia, Dysk, Gmail). |

| Project Mariner (wczesny dostęp): Automatyzacja zadań dzięki prototypowi agenta badawczego. | Project Mariner (wczesny dostęp): Automatyzacja zadań dzięki prototypowi agenta badawczego. |

| YouTube Premium (plan indywidualny): YouTube bez reklam, offline i w tle. |

Na razie plan Google AI Ultra można wykupić tylko w USA, ale - biorąc pod uwagę, że firma ujawniła już polską cenę - można oczekiwać, że wkrótce się to zmieni.

Android XR, czyli Gemini na twojej twarzy

Zgodnie z oczekiwaniami, Google zademonstrował prototyp inteligentnych okularów z Androidem XR, wyświetlaczem, głośnikami, mikrofonami i kamerą. Umieszczą one wirtualnego asystenta Gemini, Mapy, Tłumacza i inne aplikacje tuż przed oczyma użytkownika.

Choć termin rynkowego debiutu nie został określony, Google już teraz ogłosił, że okulary będą dostępne w różnych wzorach przygotowanych przez firmy Gentle Monster oraz Warby Parker. W pierwszej kolejności Android XR trafi na gogle Samsunga o kodowym oznaczeniu Project Moohan, które mają wylądować na sklepowych półkach jeszcze w tym roku.

Project Astra, czyli obsługa telefonu bez trzymanki

Google ogłosił, że tryb Gemini Live na smartfonach z Androidem zostanie wkrótce uzbrojony w agenta AI bazującego na nowej generacji technologii Project Astra. Idąc za przytoczonym przykładem użycia, telefon będzie np. w stanie odnaleźć instrukcję naprawy konkretnego roweru i - zgodnie z poleceniem - sam przewinąć dokument do rozdziału o hamulcach.

Google Beam, czyli komunikator jak z filmów sci-fi

Google Beam to zaawansowane urządzenie do komunikacji, które przypomina duży monitor 3D działający bez konieczności zakładania okularów. System jest wyposażony w sześć kamer, które w czasie rzeczywistym skanują użytkownika z milimetrową precyzją, tworząc realistyczny, trójwymiarowy model 1:1 odwzorowujący wygląd, mimikę i gesty z prędkością 60 klatek na sekundę.

Celem Google Beam jest umożliwienie dwóm osobom prowadzenia naturalnej rozmowy na odległość, dzięki wyświetlaniu ich realistycznych awatarów 3D, co ma sprawiać wrażenie fizycznej obecności drugiej osoby.

Urządzenie ma trafić na rynek jeszcze w 2025 roku. Cena nie została ujawniona, ale z uwagi na zaawansowanie technologiczne, Google kieruje produkt przede wszystkim do klientów korporacyjnych. Projekt bazuje na prototypowej technologii znanej wcześniej jako Project Starline, a w jej komercjalizacji pomogła firma HP.

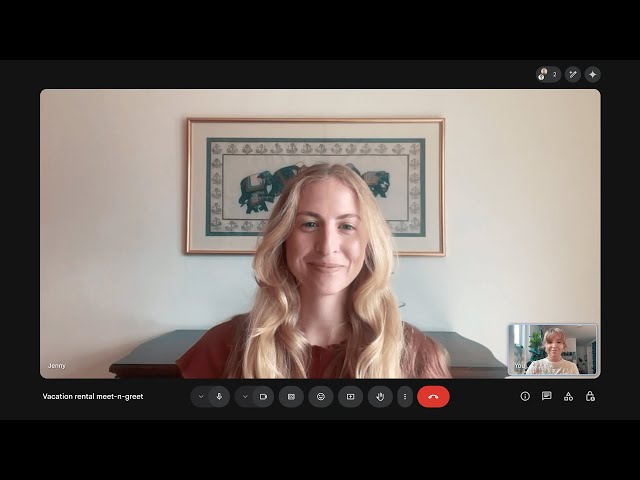

Google Meet znosi bariery językowe

Aplikacja Google Meet otrzymała właśnie funkcję tłumaczenia rozmów w "niemal czasie rzeczywistym". Przetłumaczone wypowiedzi generowane są przez syntezator mowy AI, który stara się odzwierciedlić barwy głosu i ton rozmówców.

Tłumacza w Google Meet zarezerwowano dla subskrybentów Google One AI Pro/Ultra. Na razie funkcja obsługuje jedynie język angielski i hiszpański, ale Google obsługuje wydłużenie tej listy w przyszłości.

Gemini wreszcie zmierza do Chrome’a

Choć od ubiegłego roku Google integruje Gemini z praktycznie wszystkimi swoimi aplikacjami i usługami, dotychczas szerokim łukiem omijana była przeglądarka. Teraz się to zmienia, bo Gemini zmierza do Chrome’a na Windowsa i macOS.

Na tym etapie Gemini w Chromie potrafi udzielać odpowiedzi na temat przeglądanych stron, ale w przyszłości funkcja będzie mogła podjąć działania w imieniu użytkownika i nawigować po wielu stronach jednocześnie. Póki co funkcja obsługuje tylko język angielski i zarezerwowana jest dla subskrybentów Google AI Pro i Google AI Ultra z USA. W przyszłości jej dostępność ma jednak zostać rozszerzona o nowe języki i regiony.

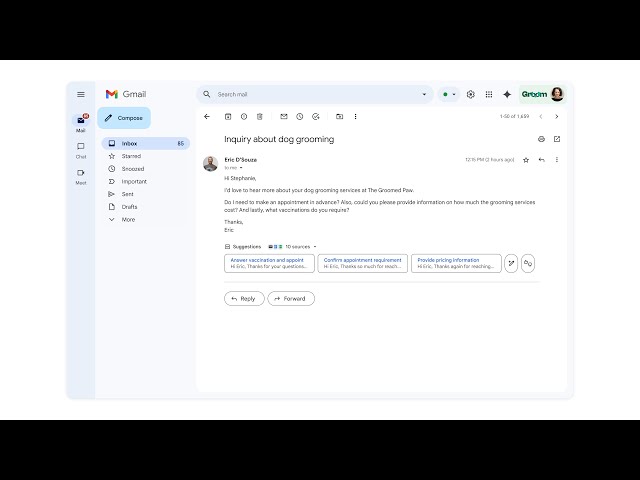

Smart Replies na sterydach, czyli Gmail sam odpisze na twoje e-maile

Funkcja Smart Replies wkrótce będzie w stanie uwzględnić osobisty kontekst. Gdy ktoś zada ci e-mailowo jakieś pytanie, Gemini będzie mógł przeanalizować dane z wcześniejszych wiadomości, notatnika Keep, Kalendarza, Dokumentów i innych aplikacji w poszukiwaniu odpowiedzi, a następnie wygenerować gotową wiadomość z uwzględnieniem stylu pisania użytkownika.

Gemini będzie mógł także na polecenie użytkownika zarządzać skrzynką. Wystarczy jedna komenda, by wirtualny asystent np. zarchiwizował wszystkie wiadomości od wskazanego nadawcy. Nowości AI w Gmailu mają być wprowadzane stopniowo do końca roku.

Zobaczymy, jak na te wszystkie nowości odpowie Apple, który na 9 czerwca zaplanował konkurencyjną konferencję WWDC25.

Komentarze

3To może być tzw. killer feature komunikatora, jeśli dodadzą więcej języków. I myślę, że może tak być nawet z abonamentem PRO (~90zł).